Part 4 Spatial Filters | Analyzing Neural Time Series Data

Chapter 22 Surface Laplacian

概述

- 采用Surface Laplacian可以突出局部的空间特征,削弱空间上广泛分布的活动

- “Surface Laplacian” 和 “Current Scalp Dencity” 的区别

- Surface Laplacian 只是一种空间滤波的方法

- Current Scalp Dencity 强调滤波后的结果

- Surface Laplacian只能用于EEG(不能用于MEG),且通常用于电极数目大于64的EEG数据

- The Laplacian is more sensitive to radial dipoles than it is to tangential dipoles.

Activity seen in the surface Laplacian is dominated (although not necessarily entirely driven) by radial dipoles in regions of the cortex close to the skull (such as gyral crowns).

The Laplacian must be applied to time-domain data, not to time-frequency data.

公式

The weights that are applied to the data such that the activity at each electrode becomes a weighted sum of activity of all other electrodes.

The cosine distance among all pairs of electrodes

The Laplacian for electrode i at one time point

The C matrix is where the data are finally introduced

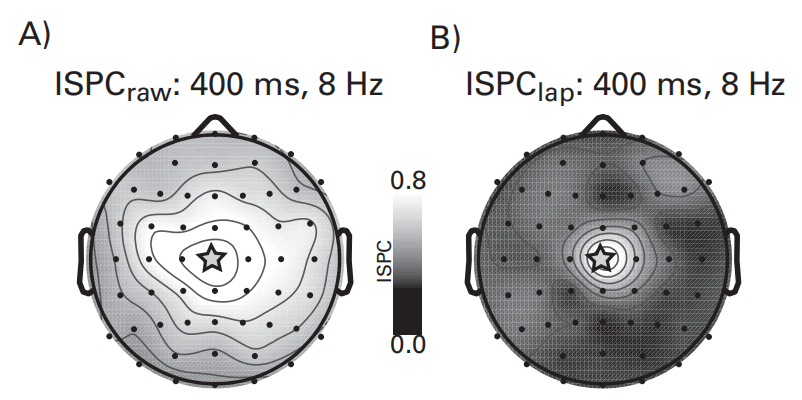

Surface Laplacian for Connectivity Analyses

- 经过Surface Laplacian的处理后,电极间信号的相关性与电极距离的联系减弱,但间隔比较近的电极仍然会相互影响,因此应该避免对间隔5cm以内的电极采用空间相关性的规律解释。

Chapter 23 Principal Components Analyses (PCA)

概述

- 与 Surface Laplacian 相反,PCA反映的不是电极的局部特征,而是弱化局部特征后的总体特征

公式

计算协方差

协方差的矩阵计算公式:

如果把电极作为变量,电极数目为变量的维度,每一个时间点下各个电极的数据看作一次观测得到的结果,组成一个列向量,那么经过多个时间点的观测后,我们可以得到一个 $electrodes(m) \times time\ points(n)$ 的矩阵$X$:

协方差公式中的$\bar{X}$是各列向量的平均值,即关于时间点的平均值,n是时间点的数目。协方差矩阵的对角线元素则为对应维度的方差

对于多个试次的数据,可以采用三种方式计算协方差:

- 先计算ERP,再以ERP作为各数据值得到矩阵$X$。该计算方法得到的是phase-locked (evoked) covariance

- 将各试次作为不同的观测点,得到的$X$矩阵有$time\ points \times trials$列,进一步以此矩阵计算协方差。得到的是total (phase-locked and non-phase-locked) covariance

- (常用)先对每一个试次计算协方差,最后平均。该方法可以提高信噪比,得到的是total (phase-locked and non-phase-locked) covariance

计算协方差矩阵的特征值和特征向量

采用matlab中的eig或svd函数计算协方差矩阵的特征值和特征向量。注意,Matlab函数eig以升序返回特征值和特征向量,但是让结果按降序排序会更直观。

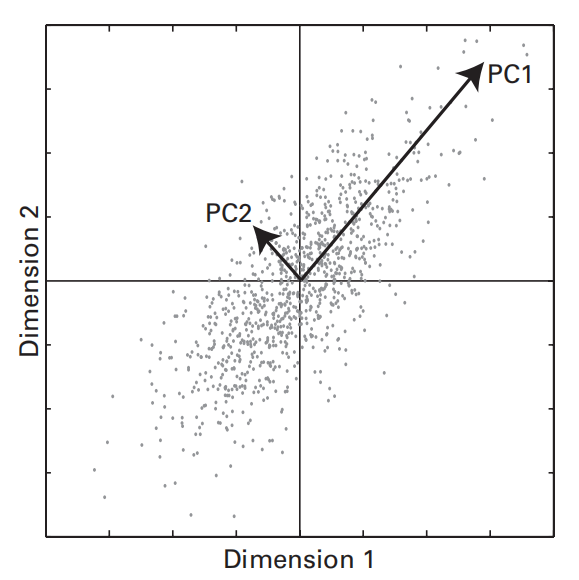

- 特征向量是旋转后的坐标轴方向

- 特征值是旋转后坐标轴的长度,经归一化可后作为对应主成分的百分比方差,即对每个特征值除以所有特征值的和,再乘以100

特征向量矩阵中的每一列都是一个主成分,其中每行元素存储对应电极的权重(weight),通常权重的正负符号不重要

结果的呈现与解释说明

- PCA map:特征向量矩阵每一列可由

topoplot绘制成一张PCA map图 - time course:将每个时间点下的各电极权重(特征向量中的一行)与电极对应的时间序列数据($X_i-\bar{X_i}$)相乘,再相加,得到一个时间点下的time course。每一个主成分(每一列)对应一个权重,也就对应一组time course(即各电极的加权和)。得到主成分时间序列数据(time course)后,可以对这些数据采用与其他时间序列数据相同的方法进行分析,比如计算ERP或时频功率等。

- 可以根据特征值的大小对主成分进行取舍

- 可以计算所有特征值比阈值低的成分对应的方差,以估计全局脑电图响应的“噪声”

- 特征值下降的快慢可以理解为系统的复杂度的大小,下降得越快,被舍弃的成分越多,系统的复杂度越小

Independent Components Analysis(ICA)

PCA和ICA的区别

- PCA的作用:去相关性、降维

- ICA的作用:分离独立源

Chapter 24 Single-Dipole and Distributed-Source Imaging

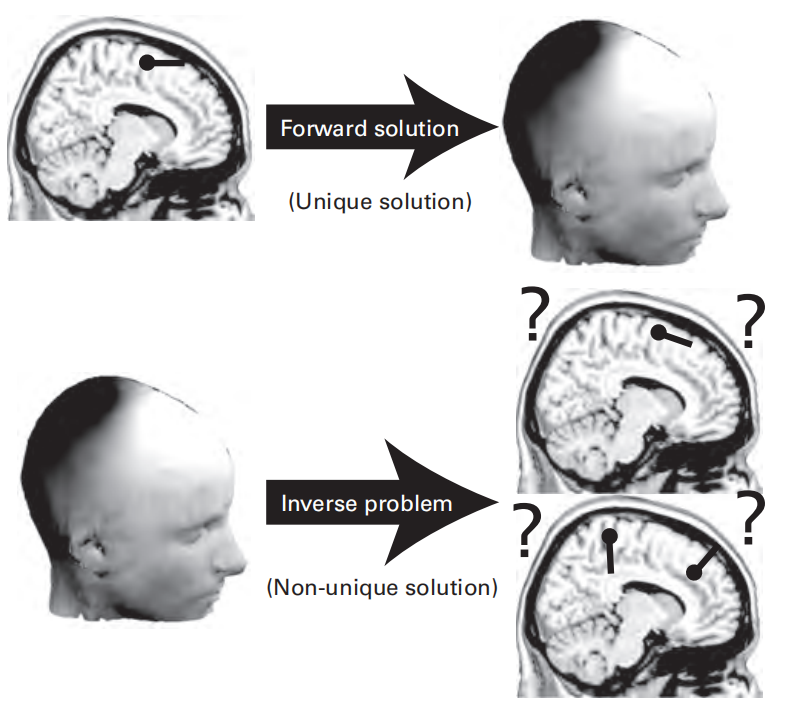

Forward Solution & Inverse Problem

Inverse Problem

- Dipole Fitting:需要确定偶极子(dipole)的位置、方向、大小

- Distributed-Source Imaging:已经确定了偶极子的位置和方向,只需要确定大小

- you should be cautious when hearing claims of functional-anatomical dissociations of less than a few centimeters based on results of source reconstruction. Such high spatial accuracy is possible but not common.